Colloquium du CMAP

Le Colloquium du CMAP, organisé 5 à 6 fois par an, propose un exposé d'ouverture à destination de tout le laboratoire CMAP, les doctorants et doctorantes sont particulièrement incité-e-s à venir. Il peut s'agir de domaines représentés dans le CMAP ou de domaines connexes (Mathématiques pures, Informatique, Physique, Biologie,...).

Le Colloquium a remplacé le séminaire du CMAP.

Prochains Colloquium

Novembre 2025

Jeudi 27 Novembre 2025 à 10h45 en salle de conférence du CMAP

Irène Waldspurger (CNRS et CEREMADE, Université Paris-Dauphine)

Titre : Low-rank optimization

Résumé : A low-rank optimization problem is a problem where one must minimize a function over the set of matrices, and the minimizer happens (or is constrained) to be low rank: its rank is much smaller than its number of lines or columns. I will introduce and motivate these problems. Then, I will explain the difficulties which arise when trying to numerically solve them, and the possible algorithmic approaches. I will in particular describe the so-called Burer-Monteiro factorization, and the theoretical as well as numerical questions it raises.

L'exposé sera précédé d'une pause café sous la verrière à partir de 10h15

Colloquiums précédents

Mercredi 15 Octobre 2025 à 10h45 (salle de conf. du CMAP)

Mazyar Mirrahimi (INRIA Paris)

Titre : How to make a reliable quantum bit?

Résumé : To fully exploit the power of quantum physics in computing, the development of fault-tolerant processors is inevitable. In such a processor, quantum bits and logical gates are dynamically and continuously protected against noise by means of quantum error correction. Although a theory of quantum error correction has existed since the mid-1990s, the first experiments are currently being realized in physics laboratories around the world. I will review the main approach followed in this direction and the progress towards fault-tolerant computing. Then I will present the cat qubit, a qubit with built-in protection, as a shortcut to reduce the hardware complexity of error correction.

Mardi 11 Mars 2025 à 11h en Amphi Becquerel

Francis Bach (INRIA, Ecole Normale Supérieure, université PSL)

Sampling Binary Data by Denoising through Score Functions

Mardi 26 Novembre 2024 à 11h en Amphi Cauchy

Cristina Toninelli (Ceremade, Université Paris Dauphine)

Bootstrap percolation and kinetically constrained models: universality results

The seminar is based on joint works with I.Hartarsky, L.Marêché, F.Martinelli, and R.Morris.

Mercredi 29 Mai 2024 à 14h en Amphi GAY LUSSAC

Nick Trefethen (Harvard University)

The AAA Algorithm for Rational Approximation

With the introduction of the AAA algorithm in 2018 (Nakatsukasa-Sete-T., SISC), the computation of rational approximations changed from a hard problem to an easy one. We've been exploring the implications of this transformation ever since. This talk will review the algorithm and then present about 15 demonstrations of applications in various areas including interpolation of missing data, analytic continuation, function extension, analysis of solutions of dynamical systems, model order reduction, nonlinear eigenvalues, and numerical computation of the Schwarz function.

Mardi 27 Février 2024 à 11h en Amphi Becquerel

Maria Esteban (CNRS et Université Paris-Dauphine)

Stabilité optimale pour les inégalités de Sobolev et de Sobolev logarithmique

Les inégalités de Sobolev et de Sobolev logarithmique jouent un rôle important dans de nombreux domaines des mathématiques. Elles sont bien comprises, ainsi que leurs fonctions extrémales.

Une question intéressante est de comprendre leur stabilité, c’est-à-dire, jusqu’à quel point ces inégalités mesurent bien la distance d’une fonction quelconque à la variété de leurs fonctions extrémales. Cette question, qu’on appelle stabilité de l’inégalité, semble simple, mais s’avère compliquée quand on cherche des réponses optimales et surtout de nature quantitative.

Récemment, avec J. Dolbeault, A. Figalli, R. Frank et M. Loss, nous avons pu donner une réponse optimale à la question en ce qui concerne l’inégalité de Sobolev, et ceci avec des bornes calculables explicitement. Nous avons également pu montrer que grâce au caractère optimal de ce résultat, une estimation pour la constante de stabilité de l’inégalité de Sobolev logarithmique avec mesure Gaussienne, et dans la norme optimale, devient possible.

Jeudi 16 Novembre 2023 13h30 - 14h30 (Amphi CURIE)

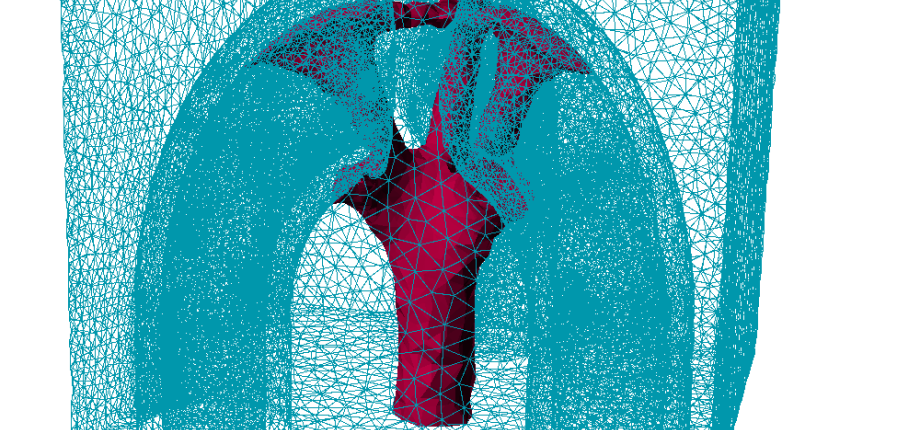

Eric Cances (Ecole des Ponts ParisTech et INRIA Paris)

Simuler la matière à partir des lois fondamentales de la physique

Dans un article fondateur de 1929, P.A.M. Dirac écrivait « les lois physiques sous-jacentes nécessaires à une théorie mathématique d’une grande partie de la physique et de la totalité de la chimie sont ainsi complètement connues, et la difficulté est seulement que l’application exacte de ces lois conduit à des équations beaucoup trop compliquées pour être résolues. Il est donc souhaitable que soient développées des méthodes d’approximation des modèles de la mécanique quantique, qui permettraient d’expliquer les propriétés de systèmes atomiques complexes sans faire trop de calculs ».

Dans cet exposé, je montrerai comment, grâce aux efforts conjoints des physiciens, des chimistes, des mathématiciens et des informaticiens, la simulation numérique de la matière à partir des lois fondamentales de la physique est aujourd'hui un outil essentiel dans de très nombreux domaines des sciences appliquées : astrophysique, physique de la matière condensée, science des matériaux, chimie, biologie moléculaire, nanotechnologies… Je monterai également que les modèles et méthodes numériques utilisés dans ce domaine reposent sur un très large spectre d'outils de mathématiques pures et appliquées. Enfin, je présenterai quelques problèmes actuellement sur le from de la recherche dans ce domaine.